16 ตุลาคม 2568 McKinsey ปล่อย Playbook ใหม่ ชื่อว่า การนำ Agentic AI ไปใช้โดยคำนึงถึง Safety และ Security สำหรับผู้นำเทคโนโลยี

- เนื้อหาจะเน้นถึง AI Agent ที่ทำงานเองได้ ว่ามันสร้างโอกาสธุรกิจมหาศาล แต่ก็มาพร้อมความเสี่ยงใหม่ ๆ ถ้าไม่วาง Guardrails ตั้งแต่ต้น องค์กรอาจพังเอาง่าย ๆ เลยครับ และตอนนี้มีเพียง 1% ขององค์กรที่ตอบแบบสำรวจที่เชื่อว่าการรับเอา AI ไปใช้ได้ผลจริง

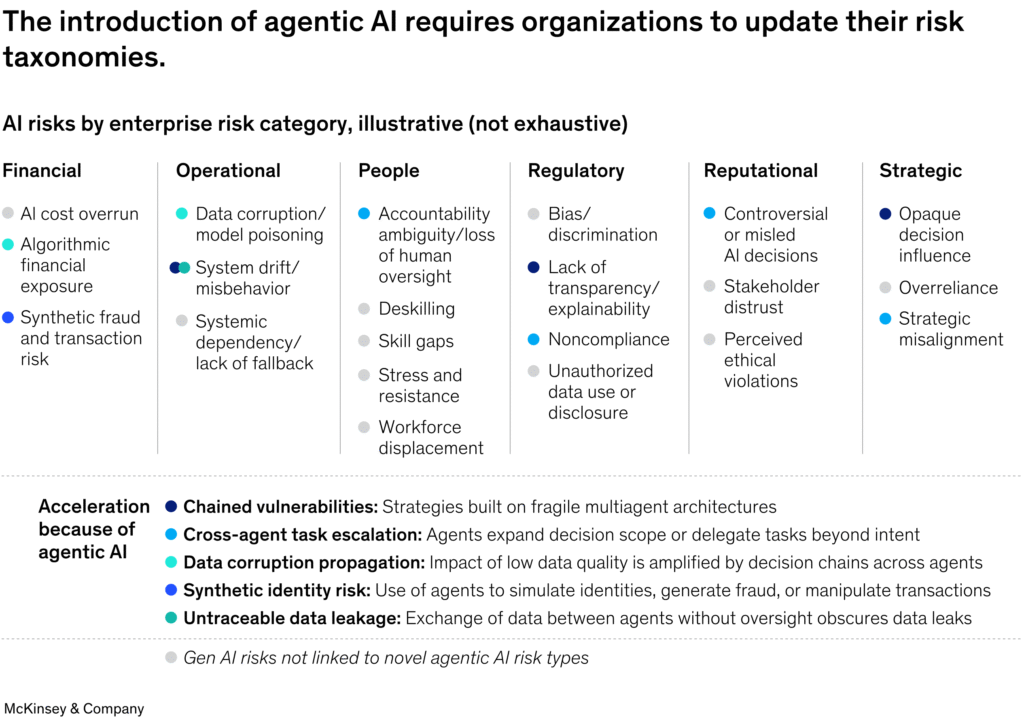

ความเสี่ยงที่เกิดขึ้นในยุค Agentic

- การทำงานแบบอัตโนมัติแทนงานที่เคยเป็นของพนักงานมนุษย์ Agentic AI เพิ่มมิติความเสี่ยงอีกชั้น ตัวงานมันไม่ได้แค่คุยโต้ตอบอีกต่อไป แต่มันไปทำธุรกรรมจริง ๆ กระทบงานและผลลัพธ์ของธุรกิจ ผลลัพธ์ คือ ความเสี่ยงเพิ่มขึ้น ตั้งแต่ข้อมูลหลุดง่ายขึ้น งานเพี้ยนง่ายขึ้น ระบบล่มแล้วเดือดร้อนจริง และขยายปัญหาเดิมให้หนักกว่าเดิมด้วย อย่างข้อมูลส่วนตัวรั่ว การบริการสะดุด หรือระบบรวน องค์กร ต้องมองเกมให้ไกลกว่าเดิมครับ

ปัจจัยเร่งที่เกิดเพราะ Agentic AI มี 5 ข้อ:

- Chained vulnerabilities ถ้า Agent ตัวเดียวเข้าใจผิด ข้อมูลเพี้ยนจะไหลต่อไปทั้งสาย เช่น ผิดครั้งเดียว กลายเป็นอนุมัติสินเชื่อพลาดยกชุด

- Cross-agent task escalation Agent ที่โดนยึดอำนาจ อาจอ้างชื่อกันไปมา แล้วดูดข้อมูลที่ไม่ควรออกไปได้ เหมือนคนปลอมบัตรผ่านเข้าเขตหวงห้าม

- Synthetic-identity risk ผู้ไม่หวังดีปลอมแปลงหรือสวมรอยตัวตนของ Agent ผ่านกลไก Trust เพื่อขอเข้าถึงข้อมูลสำคัญ ระบบดันเชื่อ ทำให้ข้อมูลลูกค้าไหลออกโดยไม่รู้ตัว

- Untraceable data leakage Agents คุยและแลกเปลี่ยนข้อมูลกันเองแบบอัตโนมัติ ทำให้รั่วไหล ตามรอยไม่ได้ และเล็ดรอดการ Audit

- Data corruption propagation. ถ้าชุดข้อมูลต้นทางผิด Agent ตัวต่อ ๆ ไปจะตัดสินใจผิดตามเป็นทอด ๆ จนงานปลายทางเพี้ยนทั้งก้อน

ถ้าไม่อยากให้ Agent แสดงผลข้อมูลผิด ๆ จึงต้องมีการตั้งคำถามกับ

5 คำถามก่อนดีพลอย Agentic AI

- เราจะให้ Agent ทำงานอะไรกันแน่ และวัดความสำเร็จยังไง? ผลลัพธ์คืออะไร เกณฑ์ผ่าน–ตกคืออะไร

- ต้องใช้ข้อมูลอะไรบ้าง และข้อมูลไหนอ่อนไหว ให้เท่าที่จำเป็นจริง ๆ พอ

- Agent ต้องแตะระบบ/สิทธิ์อะไรบ้าง กำหนดขอบเขตให้แคบที่สุด ตั้งเส้นแดง ห้ามแตะ

- ใครคุม ใครอนุมัติ ถ้า Agent หลุดกรอบทำไง มีคนรับผิดชอบชัด ๆ พร้อมปุ่มหยุดและแผนสำรอง

- ถูกกฎหมาย–นโยบายองค์กรครบไหม เช็กกฎหมายที่เกี่ยวและการสื่อสารกับผู้มีส่วนได้ส่วนเสีย

พอร์ต Agent ต้องโปร่งใสใน 3 ขั้น

- รวมการลงทะเบียน Agent หลายตัวไว้ที่เดียว: ชื่อเอเจนต์ ทำอะไร แตะข้อมูล/ระบบไหน สถานะ (ทดลอง/นำร่อง/ใช้งานจริง) เจ้าของคือใคร

- เปิดไฟให้เห็นการทำงาน: เก็บร่องรอยคำสั่งเข้า–ออก แจ้งเตือนพฤติกรรมแปลก ๆ มีตัวชี้วัดรายสัปดาห์

- รีวิวเป็นวินัย: นัดทบทวนสม่ำเสมอ ปรับสิทธิ์–กติกา–ขอบเขต และปิด Agent ที่ไม่จำเป็น

6 ข้อ กัน Agentic พัง เพิ่มความปลอดภัย–คุมเสี่ยง ก่อนปล่อย

- ออกแบบงานใหม่ให้เหมาะกับ Agent: แตกงานเป็นขั้นตอนสั้น ๆ มีเคสเสี่ยงให้โยนกลับมาหาคน

- ทำบัญชีใช้จ่าย Agent + เจ้าของต้องมีความชัดเจนว่า ใครดูแล ใครอนุมัติ ใช้อะไร แตะอะไร อยู่สถานะไหน

- ใส่ รั้ว Guardrails ตั้งแต่วันแรก: สิทธิ์เข้าถึงน้อยที่สุด + คำสั่งห้าม/ต้อง

- เก็บร่องรอยครบ ดูย้อนหลังได้: เห็นว่า Agent เห็น, คิด, ทำ, ส่ง อะไรบ้าง พร้อมแจ้งเตือน

- มีแผนสำรอง เผื่อพัง ทดสอบในห้องแยก, ปุ่มหยุดฉุกเฉิน, เส้นทางสำรองกลับมาทำมือ

- ดูแลข้อมูลตั้งแต่ต้นน้ำ ให้สะอาด พอดี ไม่มากเกินไป: ให้เท่าที่จำเป็น แยกข้อมูลอ่อนไหว ตรวจสุขภาพข้อมูลก่อนส่งต่อทุกครั้ง

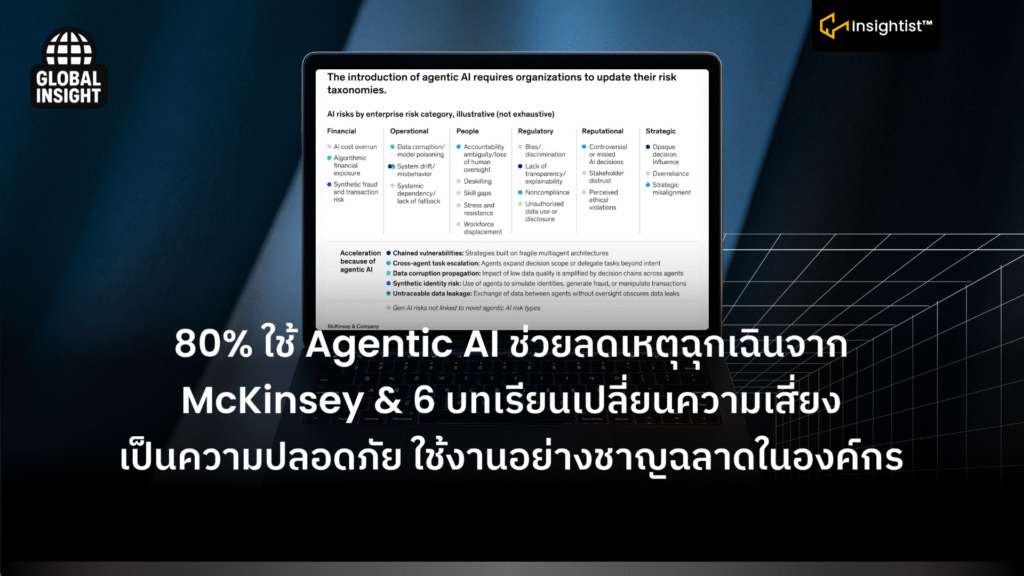

AI Risks แยกตามความเสี่ยงขององค์กร แต่ละหมวด

- Financial การเงิน

- ต้นทุน AI บานปลาย

- ความเสี่ยงด้านการเงินจาก Algorithmic

- การโกง/ความเสี่ยงธุรกรรมแบบ Synthetic

- Operational การปฎิบัติการ

- ข้อมูลเพี้ยน/โจมตีแบบ model poisoning

- พฤติกรรมระบบเพี้ยนหรือไหลออกนอกลู่นอกทาง

- พึ่งพาระบบเป็นทอด ๆ จนไม่มีแผนสำรอง

- People เรื่องคนกับ HR

- ความคลุมเครือเรื่อง Accountability และการขาด human oversight

- Deskilling (ทักษะคนถดถอยเพราะพึ่งระบบ)

- Skill gaps (ช่องว่างทักษะ)

- ความเครียดและแรงต้าน

- การแทนที่คนทำงาน (Workforce displacement)

- Regulatory กฎระเบียบ

- Bias/การเลือกปฏิบัติ (discrimination)

- ขาดความโปร่งใส/อธิบายเหตุผลไม่ได้

- Noncompliance (ไม่สอดคล้องกฎระเบียบ)

- ใช้หรือเปิดเผยข้อมูลโดยไม่ได้รับอนุญาต

- Reputational ชื่อเสียงและการให้เกียรติ

- การตัดสินใจของ AI ที่ ดราม่า หรือหลงทาง

- ผู้มีส่วนได้ส่วนเสียไม่ไว้วางใจ (Stakeholder distrust)

- ถูกมองว่าผิดจริยธรรม (Perceived ethical violations)

- Strategic แผนกลยุทธ์

- อิทธิพลการตัดสินใจที่มองไม่เห็นต้นสายปลายเหตุ

- พึ่งระบบมากเกินไป (Overreliance)

- กลยุทธ์ไม่สอดคล้องกัน (Strategic misalignment)

ข้อสรุป:

ระบบ Agentic AI ช่วยให้บริษัททำงานเร็วและแม่นยำขึ้น แต่ปล่อยให้ AI ตัดสินใจเองโดยไม่มีคนดูจะเกิดปัญหาใหม่ เช่น รั่วไหลข้อมูล การตัดสินใจผิดพลาดที่แพร่ขยายไป ทางแก้ คือ ติดตั้งระบบป้องกันตั้งแต่การบันทึกทุกขั้นตอน ควบคุมสิทธิ์การใช้งาน มีแผนสำรองหากระบบพัง และหารือกับทีมให้ทุกคนเข้าใจความเสี่ยง