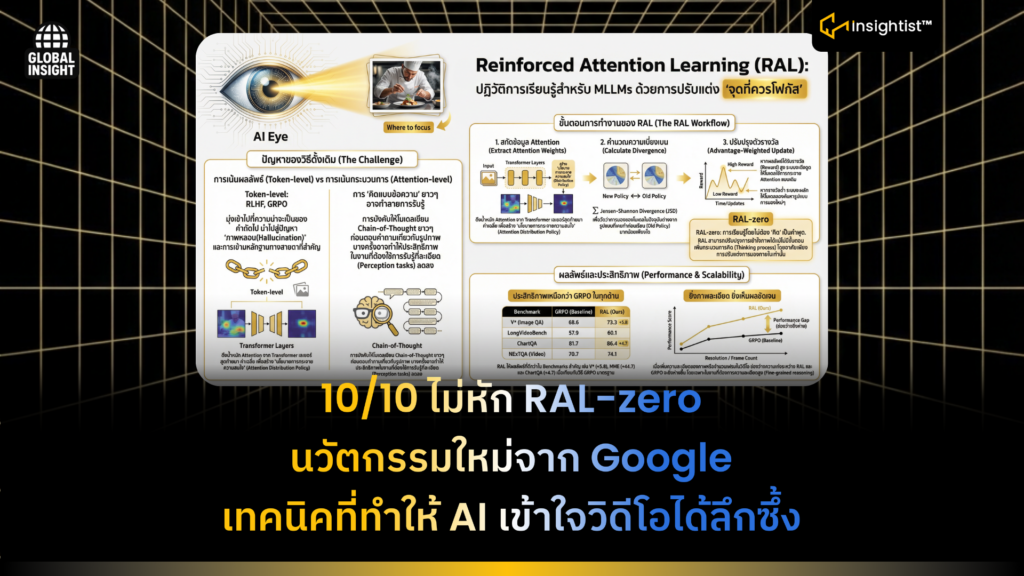

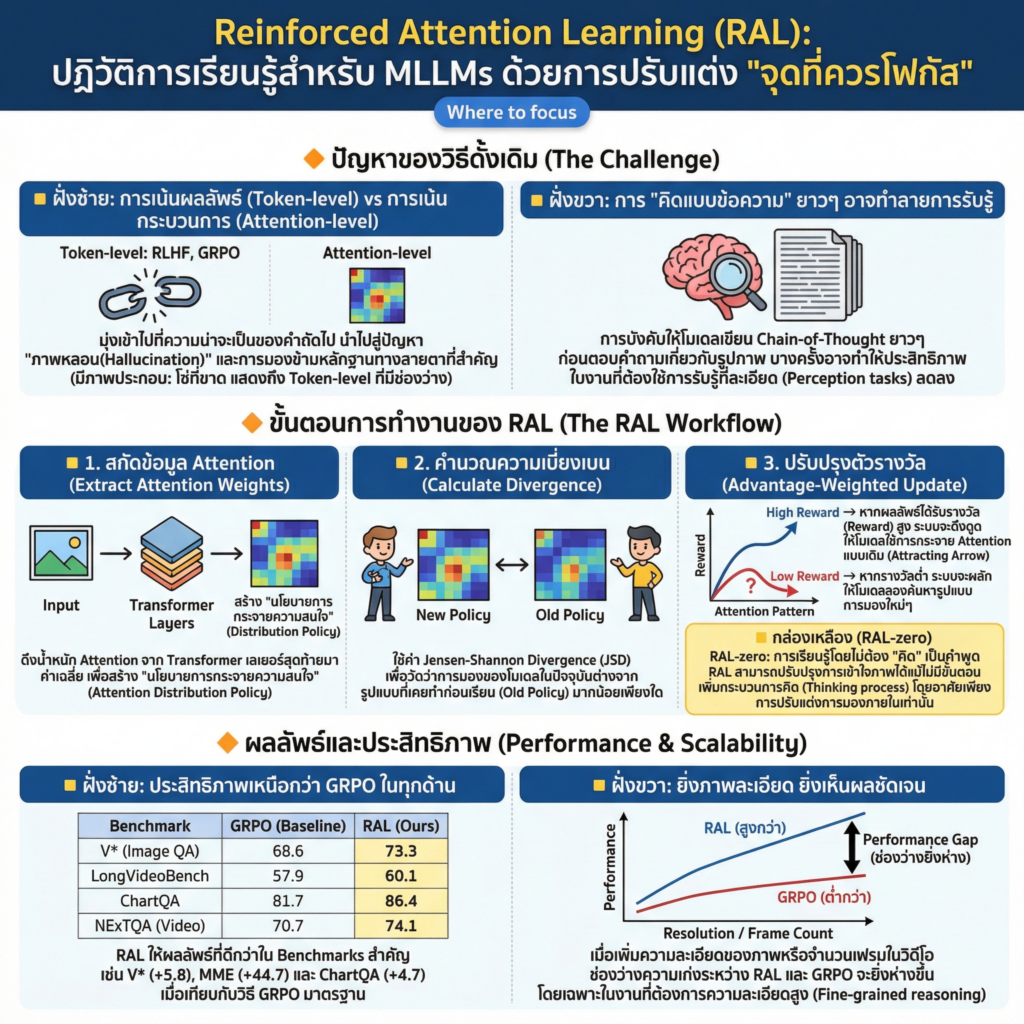

บทความวิจัยนี้นำเสนอแนวคิดการปรับแต่งโมเดลภาษาขนาดใหญ่แบบต่อเนื่อง (Post-training) โดยเปลี่ยนจุดเน้นจากการสอนให้โมเดลสร้างข้อความที่ถูกต้องเพียงอย่างเดียว ไปสู่การให้รางวัลแก่โมเดล เมื่อมีรูปแบบการจัดสรรความสนใจ (Attention Distributions) ภายในที่เหมาะสมกับข้อมูลภาพและวิดีโอ

4 กุมภาพันธ์ 2569 Google Deepmind ร่วมกับ UC Davis, Princeton University ทำวิจัยและเผยแพร่ เรื่อง Reinforced Attention Learning (RAL) เป็นเทคนิคใหม่ที่มาเขย่าวงการ AI สาย Multimodal (พวกที่อ่านภาพและวิดีโอได้)

ปัญหาของ AI ในปัจจุบัน: มัวแต่คิด จนลืมมอง

- ปกติเวลาเราฝึก AI ให้เก่งขึ้น เรามักจะใช้การให้รางวัล (Reinforcement Learning) เมื่อมันพูด หรือ พิมพ์คำตอบได้ถูกต้อง

- Pain Point: พอเป็นงานที่ต้องดูรูปหรือวิดีโอ การให้ AI มานั่งเขียนอธิบาย ยาวๆ (Chain-of-Thought) ก่อนตอบ บางทีมันไม่ได้ช่วยให้มองภาพเก่งขึ้นเลย แถมบางครั้งทำให้ประสิทธิภาพการรับรู้แย่ลงด้วย

- ปัญหาก็ คือ AI มักจะโฟกัสผิดจุดในภาพ การฝึกแบบเดิมมันไปแก้ที่ ผลลัพธ์ (คำพูด) แต่ไม่ได้แก้ที่ กระบวนการ (การเลือกมองข้อมูล)

รู้จัก RAL Framework: ฝึกที่สายตา ไม่ใช่แค่คำพูด

- แทนที่จะสั่งว่า จงพิมพ์คำตอบที่ถูก RAL เปลี่ยนมาสั่งว่า จงมองไปที่จุดที่สำคัญที่สุด

โครงสร้างของ Framework นี้ประกอบด้วย 3 ส่วนหลัก

- เปลี่ยน Attention ให้เป็น Policy:

- งานวิจัยนี้มองว่า การกระจายความสนใจ (Attention Distribution) ในหัวของ AI คือ นโยบาย (Policy) รูปแบบหนึ่ง จึงเข้าไปกำกับการทำงานของ Transformer ใน Layer สุดท้าย เพื่อดูว่า AI โฟกัสไปที่ Token ไหนของภาพหรือวิดีโอบ้าง

- การคำนวณรางวัลแบบ Divergence:

- ถ้า AI ตอบถูก (ได้รางวัลสูง): ระบบจะบังคับให้มันจำว่า จังหวะนี้ต้องมองแบบนี้นะ

- ถ้า AI ตอบผิด (ได้รางวัลต่ำ): ระบบจะผลักไสมันออกจากการมองแบบเดิม เพื่อให้มันไปหาวิธีมองจุดอื่นในการประมวลผลครั้งหน้า

- การฝึกแบบ Dual Objective:

- เขาไม่ได้ทิ้งการฝึกพิมพ์คำตอบนะ แต่เอาการฝึกการมอง (Attention RL) บวกกับการฝึกการพูด (Token RL) เพื่อให้ AI ทั้งมองและพูดเก่งไปพร้อมๆ กัน

ระบบการสอนงาน: On-Policy Attention Distillation

- มีสูตรลับในการสอน AI ตัวเล็กให้เก่งเหมือนตัวใหญ่ด้วย:

- ปกติการสอน (Distillation) จะเน้นให้ตัวเล็กพิมพ์ตามตัวใหญ่

- RAL เทคนิคนี้จะสอนให้ตัวเล็ก เลียนแบบพฤติกรรมการมอง ของตัวใหญ่ด้วย ทำให้ AI ตัวเล็กสามารถรับเอาไหวพริบการมองจุดสำคัญ จากตัว Top มาได้แม่นยำกว่าเดิม

ผลการทดสอบ

- ทีมวิจัยทดสอบกับโมเดล Qwen-2.5-VL-7B บนสนามสอบหินๆ ทั้งภาพและวิดีโอ:

- ชนะขาดลอย:

- RAL ทำคะแนนได้ดีกว่าระบบเดิม (เช่น GRPO) ในเกือบทุกด่าน โดยเฉพาะงานที่ต้องตาไว และ มองละเอียด

- ยิ่งยาก ยิ่งเทพ:

- เมื่อเพิ่มความละเอียดของภาพหรือเพิ่มจำนวนเฟรมในวิดีโอ RAL จะทิ้งห่างคู่แข่ง เพราะมันจัดการกับข้อมูลมหาศาลได้ฉลาดกว่า ไม่หลงประเด็น

- RAL-zero (จุดพีก):

- พิสูจน์ให้เห็นว่า แม้จะตัดขั้นตอนการ Think ออกไปเลย AI ที่ฝึกด้วย RAL ก็ยังฉลาดกว่าเดิมมาก นั่นเพราะสายตาของมันถูกฝึกมาให้เลือกดูเฉพาะสิ่งที่จำเป็นต่อการตอบคำถามได้ด้วยตัวเองแล้ว

ข้อสรุป:

RAL คือ การเปลี่ยนจากการฝึก AI ให้พูดให้ถูกมาเป็นฝึกให้, มองให้เป็นหัวใจสำคัญที่ทำให้ AI เข้าใจภาพ, VDO ได้ลึกซึ้งเหมือนมนุษย์จริงๆ