ช่วงนี้ AI ในวงการสุขภาพไม่ได้โตแบบค่อย ๆ แล้วครับ…มันโตแบบ “เอาไปทำงานจริง” มากขึ้นเรื่อย ๆ

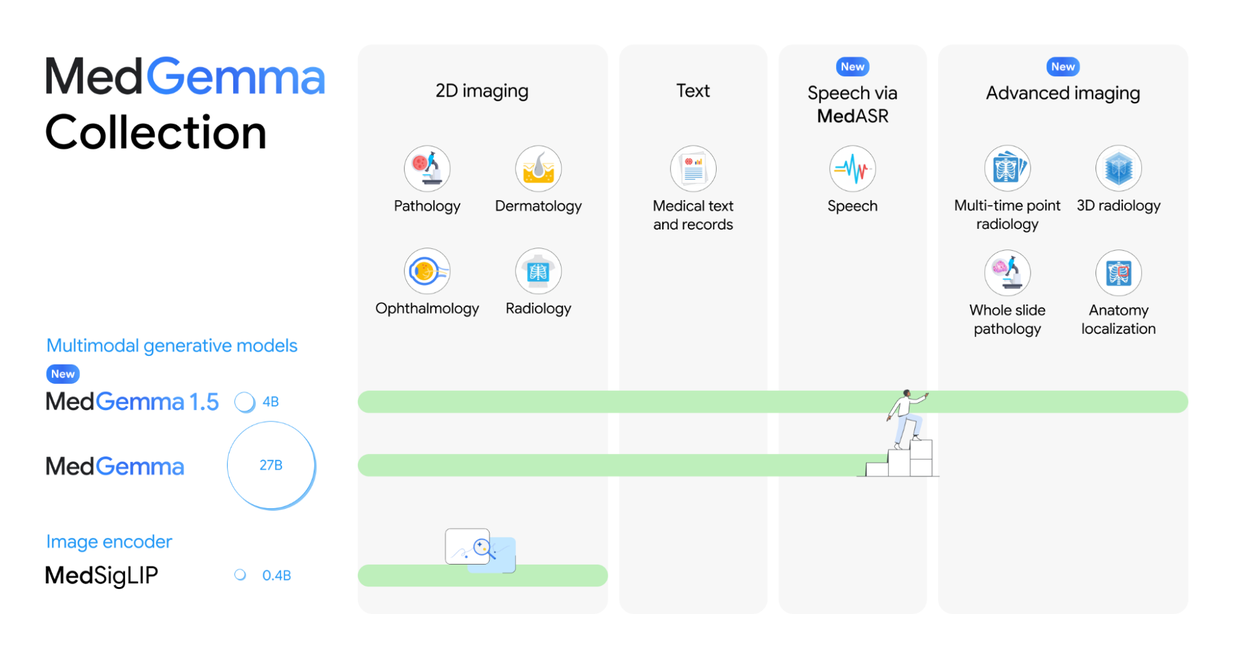

13 มกราคม 2569 Google Research จึงอัปเดตโมเดล Open-Source สำหรับสายแพทย์เป็น MedGemma 1.5 (ขนาด 4B) สามารถอ่านภาพทางการแพทย์ได้ดีขึ้น + รองรับงานหลายมิติมากขึ้น และยังเป็นโมเดลขนาดที่เริ่มต้นได้คุ้ม สำหรับทีมพัฒนา

จุดเด่น คือ อ่านภาพทางการแพทย์ได้เก่งขึ้น และตั้งใจให้เป็น Starting point สำหรับทีมที่อยากเอาไปปรับใช้กับงานจริง ทั้ง

- การวินิจฉัยโรค

- การตัดสินใจจัดการผู้ป่วย

- คำแนะนำการรักษา

MedGemma 1.5 ต่างจากเดิมตรงไหน?

- ขยายจากภาพ 2D → ภาพแบบ High-Dimensional (ละเอียดสูง)

- รองรับงานอย่าง CT / MRI / histopathology มากขึ้น หมายถึง จากเดิม

- ดูภาพทีละใบ → อ่านภาพเป็นชุด ๆ / หลายชั้น / หลายมุมได้ดีขึ้น

- ทำงานกับ ภาพที่ต้องเทียบเวลาได้ดีขึ้น

- เช่น ดู Chest X-ray คนเดิมหลายช่วงเวลา เพื่อจับการเปลี่ยนแปลง

- มีความสามารถด้าน Anatomical Localization

- ช่วยชี้ตำแหน่งโครงสร้างสำคัญในภาพ (เช่นใน chest X-ray) ได้ดีขึ้น อันนี้สำคัญมาก เพราะทำให้ผลลัพธ์อธิบายได้มากขึ้น ไม่ใช่แค่ตอบว่าพบอะไร

- เข้าใจเอกสารแพทย์ดีขึ้น

- ดึงข้อมูลจาก Medical Lab Reports ให้เป็น Structured data (ชนิดแล็บ / ค่า / หน่วย)

คุณเข้าถึง Variant ทั้งหมดของ MedGemma ได้ผ่าน

- Hugging Face collection

- Vertex AI บน Google Cloud

ส่วน MedASR มีให้ใช้บน Hugging Face และ Vertex AI แล้วเหมือนกัน

ข้อสำคัญ

MedGemma และโมเดลใน HAI-DEF ถูกวางเป็น starting point ไม่ควรใช้ผลลัพธ์ไปตัดสินใจทางคลินิกโดยตรง โดยไม่ผ่านการ validate / adapt ให้เหมาะกับ use case ขององค์กร

ข้อสรุป:

MedGemma 1.5 (4B) คือ อีกก้าวที่ทำให้ AI สายสุขภาพ “อ่านภาพได้หลากหลายขึ้น” และต่อยอดเป็นระบบช่วยงานได้มากขึ้น แต่ของจริงจะเวิร์กได้ ต้องชนะ 3 เรื่อง: ข้อมูล + การปรับใช้ + ความปลอดภัย